Ämnet är - som lätt framgår av längden och antalet svar - inte lätt. Det betyder också att det beror mycket på alla specifika fall för att svara på det här ämnet.

Del I:

Om vi definierar att processparametern ($ p $) har som ska övervakas. Mätningen ($ m $) för processparametern innehåller alltid en osäkerhet ($ u $). Så låt oss ange följande modell:

$ m = p + u $

Syftet med varje kalibrering är att specificera osäkerheten. Strikt talat kan osäkerheten bara specificeras för den kalibrering som redan gjorts. Ett mycket rimligt antagande är dock att osäkerheten inte kommer att förändras dramatiskt. Men det kommer att förändras med tiden. Så modellen kommer att se ut så här:

$ m = p + u (t) $

Din föreslagna redundans har olika effekter på osäkerheten, beroende på hur redundans uppnås. Ett sätt kan vara att mäta samma processparameter med en ytterligare sensor av samma typ (1). Ett annat sätt skulle vara att antingen använda en annan sensor (2) eller till och med observera en annan processparameter med en annan sensor (3).

Att bara använda samma sensor för att observera samma parameter kommer sannolikt att ha en liknande försämring av kalibreringskvaliteten. Eftersom orsaken till nedbrytningen inte ändras, så har båda sensorsignalerna möjligen en högre osäkerhet över tiden.

De två andra alternativen har potential att komma med en osäkerhetsmodell som inte skulle göra kalibreringen onödigt men kan öka omkalibreringsperioderna.

Del II:

Det finns i alla fall en betydande skillnad mellan fel och osäkerhet . Om det skulle vara möjligt att veta felet i varje mätning kan man enkelt kompensera för det.

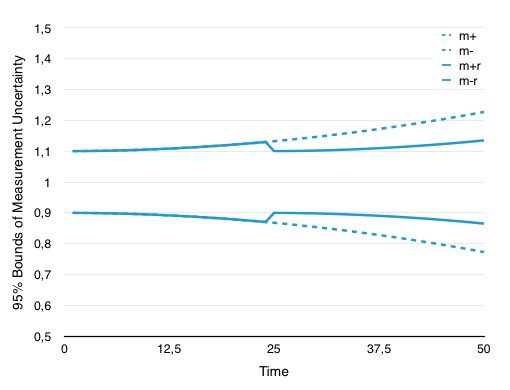

Men det enda en kalibrering kan ge är osäkerheten i en mätning. Eller sätt det tvärtom en kalibrering ger dig en uppskattning av hur säker man kan vara att i (vanligtvis) 95% av alla mätningar kommer det returnerade värdet att vara i det angivna intervallet runt det sanna värdet. Följande bild visar det övre och lägre gränser för osäkerheten förutsatt en mycket enkel nedbrytningsmodell.

Förutsatt att du vill behålla din processparameter på nivån "1" och din osäkerhet har ett initialvärde på +/- 10% (vilket är enormt men trevligare att illustrera). Anledningen till att du först måste kontrollera parametern är att du måste bevisa att din process (eller produkt) har en specifik kvalitet. Eftersom det lätt kan ses utan omkalibrering (gränser m + och m-, prickade) efter en del imaginär tid har osäkerheten ökat stadigt. Genom att kalibrera om mitt i intervallet minskar du osäkerheten (m + r och mr, fast).

Från din beskrivning antar jag att du måste rapportera eller spara kalibreringen före och efter varje period tillsammans med mätningsloggen för processen för att bevisa din kvalitet under hela produktionscykeln. Det enda sättet att göra det är att samla mer kunskap om denna specifika process.

Just nu är brute-force-metoden att kalibrera två gånger och anta osäkerheten mellan dessa kalibreringar var inom de två kalibreringarna.

Om det skulle vara möjligt att få en bättre modell för osäkerhetsnedbrytningen kan antalet kalibreringar minskas. För att få en bättre modell är det dock nödvändigt att kombinera ett större antal kalibreringar. Ett möjligt sätt kan vara att använda alla tillgängliga kalibreringar och omkalibrering. Det kan vara möjligt att utveckla en bättre förståelse för osäkerheten och därigenom utveckla en bättre modell som skulle förlänga kalibreringsintervallen.

Till exempel med tanke på att sensorerna skulle försämras på det sätt som visas i figuren ovan, en lösning kan vara att ändra kontrollparametrarna för produktionssystemkontrollen över tid. Men sättet att göra detta eller om detta till och med är möjligt beror mycket på din process som vi inte vet ännu.

Slutligen, även om det är kontraintuitivt med redundanta sensorer, minskar inte nödvändigtvis osäkerheten.

Genom att lägga till en extra sensor av samma typ i systemet fördubblar du i princip antalet mätningar och håller samma osäkerhet. Det enda sättet en redundant sensor minskar osäkerheten är när den första sensormätningen inte var representativ för systemet och inte bara hade osäkerhet från sensorn utan ytterligare fluktuationer från själva systemet. Tänk på en mätning som att skjuta mot ett mål. Beroende på dina färdigheter har du en viss sannolikhet att slå bulls eye. Det innebär att genom att skjuta oftare ökar du bara att slå bulls eye men du minskar aldrig spridningen av dina skott. Varje skott har samma sannolikhet att träffa bulls eye. På samma sätt ökar mätningen oftare chansen att mäta det "rätta" värdet, men det är inte intressant här. Det är av intresse hur säker du kan vara att varje uppmätt värde ligger inom ett visst "intervall runt" rätt värde.

Sammanfattar det:

-

Att lägga till sensorer i en mätning minskar inte nödvändigtvis osäkerheten för den kombinerade mätningen.

-

Att ha två sensorer av samma typ ändrar inte nedbrytningshastigheten för det kombinerade mätvärdet jämfört med en enda sensor.

-

Om möjligheten är stor att en sensor skulle ge felaktiga värden under produktionskörningen, än att ha redundanta sensorer är mycket meningsfullt. Men detta har ingenting att göra med värdenas osäkerhet. I det här fallet skulle efterkalibreringen avslöja att processen inte övervakades ordentligt på grund av sensorfel så det finns inget sätt att säkerställa kvaliteten på produktionskörningen alls. I händelse av sensorfel skulle den andra sensorn ha sparkat in och (i bästa fall) gett samma kvalitet som om en sensor skulle ha överlevt hela produktionskörningen.

-

Det enda sättet att minska antalet kalibreringar är att samla alla kalibreringar från det förflutna och försöka bygga en sensor-nedbrytningsmodell utifrån den som kan visa att det nuvarande antalet kalibreringar är onödigt högt.

-

Genom att använda olika sensortyper eller mätning av processparametrar kan det vara möjligt att komma fram till en osäkerhetsmodell som försämras långsammare och är mer robust med avseende på sensorfel.